作者:2017级本科生 陈华玉 自动化系

指导老师:刘烨斌 自动化系

关键词:虚拟换装 视频 自动化

摘要

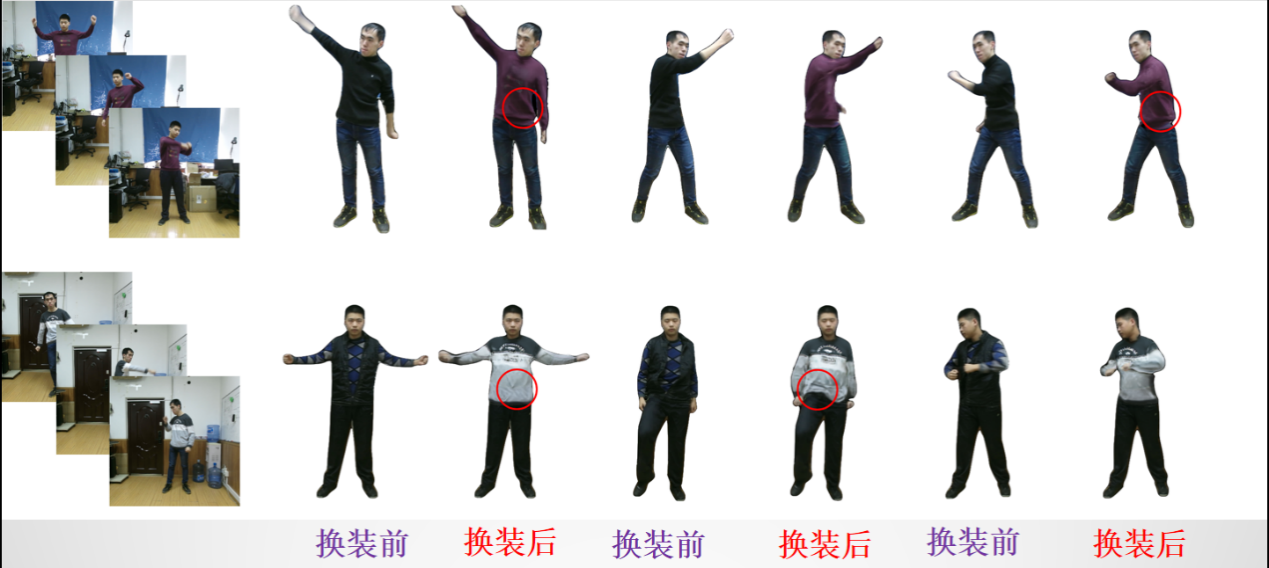

虚拟换装问题是计算机视觉领域的一个子问题,也是该领域公认的难题。在此,我们提出一种自动化的、基于三维人体模型和对抗生成网络的视频级别虚拟换装系统。给定模特在深度相机前拍摄的普通视频以及对应的深度视频流,我们的系统可以将该模特的服装替换为指定的另一件服装,并输出同一位模特具有相同动作的对应换装后视频。我们的解决方案包括以下步骤:(1)人体与服装模型的三维重建与融合。(2)三维融合模型到二维的投影与基于对抗生成网络的优化。

图1 动态换装效果对比

系统功能

我们的虚拟换装系统有两个功能:1. 对穿在人身上的服装进行三维建模并解耦合出来。2. 给用户进行虚拟换装。

为了完成功能一: 比如我们想收集一件衣服的三维信息,我们只需要让一个模特穿着这件衣服,在我们的采集系统前转一圈然后做一些常见的动作,拍摄1-2min的视频。仅仅从这样的一个深度视频中,我们就可以解析出该服装的相关信息和特性。

为了完成功能二: 比如我们已经收集到了上述服装的信息。那么下面来一个顾客,只需要在我们的相机前做一些动作,拍摄一个小视频(时长不限)输入,那么我们的系统就会输出一个对应的视频:输出视频就像是输入视频的镜像一样,除了顾客的服装改变以外,其余的背景,动作,表情等都一模一样。

系统接口

一般而言,一架深度相机是唯一必备的硬件设备。

我们在该任务中仅使用了一架 Kinect 相机和一个搭载常见显卡的计算平台。

系统的输入仅仅是一个深度相机拍摄的视频,而输出则是rgb视频。

创新点

据我们所知,我们做了在虚拟换装(Virtual Try-on)研究领域第一次从图形层面(非物理仿真)考虑服装动态特性的尝试。我们将传统三维重建算法与机器学习算法结合起来,一定程度上降低了系统成本。