智能感知导盲杖

23自动化系

作品介绍

智能感知导盲杖

作者:冀泽华 江德扬 童宇昂 余孟繁 董岩 自动化系

指导老师:张涛 自动化系

关键词:智能辅助设备 环境感知 LSTM 注意力机制

摘要

本项目旨在设计一款能够帮助视障人士更好地感知周围环境的智能导盲杖。该导盲杖使用了近几年兴起的image-caption技术。盲杖使用单目相机对周围环境进行拍摄,然后使用socket通信将图片传输至服务器。服务器使用基于pytorch框架和注意力机制的图像转文字(image-caption)技术,将输入的图片通过LSTM模块输出为完整的描述。然后再将描述传回导盲杖。盲杖最终使用翻译模块将英文描述转换为中文释义,通过语音输出模块输出给盲人,以实现帮助盲人感知周围环境的目的。

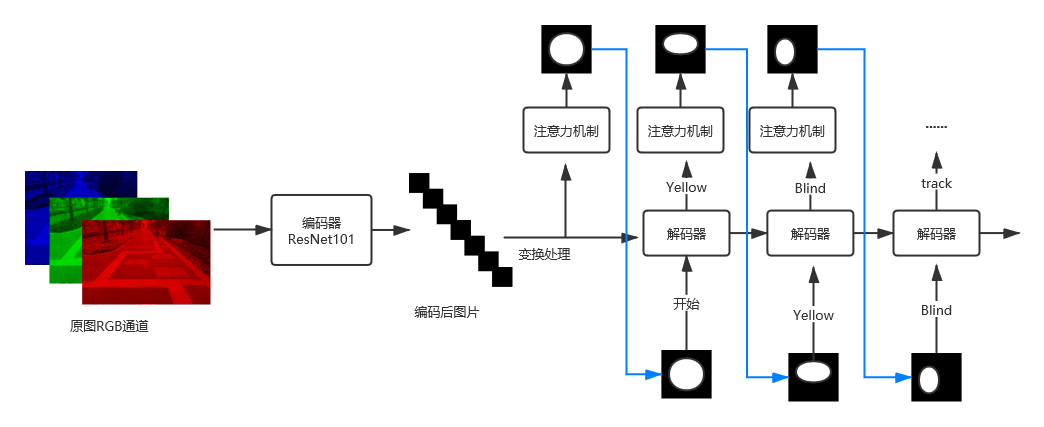

网络简述

算法主要由编码器,解码器和注意力机制组成。编码器用于将原始图片通过卷积神经网络进行编码;解码器是基于长短期注意力机制的语句生成模块;注意力机制和解码器相互配合,生成图片中各个像素点的权值,即注意力。解码器通过注意力学习生成图片的描述。

1 注意力机制网络图

效果展示

在一定的范围内达到了良好的准确度和精准率,可以通过翻译和语音合成再经有扬声器将语音信号传递给视障人士,实现指引视障人士出行的功能。

2 效果展示图

成品展示

最终,我们得到了如下的导盲杖样品,该导盲杖依托顶部的按钮,通过按下按钮启动,实现树莓派与服务器之间的通信,最终将传输的结果通过下部的扬声器传递出来。

3 导盲杖实物展示

评论 文明上网理性发言,请遵守评论服务协议

登录 登录后可以发言~

全部评论